株式会社PLAYでiOSエンジニアをしております鈴木斗夢と申します。

WWDCのApple Intelligenceに関する発表がかなり刺激的だったのでご紹介いたします。

- Apple Intelligenceとは何か

- Apple Intelligenceは私たちの生活をどう変えるか

- ChatGPTとの連携

- 「当たり前になりつつある」AI機能も実装

- そんなに個人情報を渡して大丈夫なの?

- Apple Intelligenceはディベロッパーに何を求めるか

- Apple Intelligenceの注目度を可視化してみる

- 海外ユーザーの声と評価

- Apple Intelligenceのユーザー利用調査について

- 最後に

- 参考

Apple Intelligenceとは何か

- Appleが提供するAIプラットフォーム

- アプリケーションと連携することが可能

- ユーザーも開発者も無料で利用可能

Apple Intelligenceは、AI技術を活用し、Appleデバイスやサービスとの統合を通じて、個々のユーザーに最適化された体験を提供するためのエコシステムです。

Apple Intelligenceは私たちの生活をどう変えるか

WWDC 2024 基調講演で発表された内容と

すでに利用が開始している海外ユーザーやサービスから

Apple Intelligenceが私たちに何をしてくれるのか見ていきましょう。

画面の内容を認識する

個人的に一番便利だなと思った機能からご紹介します。

Apple Intelligenceが画面に表示されている情報を理解するようになりました。

例えば、友人がメッセージで『今週日曜日の17時に渋谷ハチ公前集合ね』と送ってきた場合、

「この約束をカレンダーに追加して」とSiriに指示するだけで、Apple Intelligenceが内容を理解してカレンダーに登録してくれます。

免許証の写真からフォームに自動入力

オンラインフォームへの個人情報の入力って面倒ですよね。

しかし、Apple Intelligenceの登場でこの作業が劇的に変わります。

フォームで運転免許証番号の入力が必要になった時、Apple Intelligenceが写真アプリにある免許証の画像を探し出して自動的に番号を読み取り、フォームに直接入力してくれるようになります。

Apple Intelligenceは:

- 写真アプリの中から運転免許証の写真を探し出す

- 必要な番号の位置を特定

- フォーム上の適切な入力欄を認識

- 抽出した情報を正確に入力

といった一連の処理を自動的に行います。

この機能はクレジットカード番号やマイナンバー関連の身分証明書の情報入力にも応用できそうですね。

面倒な手作業から解放されることで、オンラインでの各種申請や登録がよりスムーズになることが期待できます。

Apple Intelligenceは、私たちの『当たり前の煩わしさ』を解消してくれるでしょう。

「妻がこの前送ったポッドキャストを再生して」 に応えるSiri

この機能には衝撃を受けました。

タイトルの通りですが、

例えば「妻がこの前送ってきてたNHKニュースのポッドキャストを再生して」とSiriに話しかけると、ポッドキャストが起動して再生されるそうです。

これが実行可能と言うことは、Apple Intelligenceが以下の能力を持つことを示しています。

- パーソナルな関係性の理解("妻"という関係性を認識)

- 時間的な文脈の理解("この前"という時間的な指示を理解)

- メッセージやコミュニケーション履歴の把握(妻が送ってきたコンテンツを認識)

- 適切なアプリケーションでの実行(ポッドキャストアプリでの自動再生)

Apple Intelligenceがデバイス内の情報から私たちを完全に理解することを示唆しています。

「まるで秘書のような」スケジュール管理をするApple Intelligence

この機能には感動を覚えました。

例えば、

- 今日の夜に妻と青山で夕食をする予定

- しかし、突然チームメンバーから会議の予定を午後の遅い時間に変更を依頼するメッセージが届いた。。

このような状況下で、

Apple Intelligenceは:

妻が数日前にメッセージで送ってきた今日の予定をチェック

- 開始時間:午後7時30分

- 場所:青山◯◯レストラン

変更された会議の情報をメッセージやカレンダーから確認

- 会議の終了予定:午後7時

- 会議の場所:渋谷オフィス

オフィスからレストランまでの移動時間を計算

- 最適な移動手段の提案(電車・タクシーなど)

- 現在の交通状況も考慮

- 渋谷駅の混雑状況

- 電車の遅延情報

- 道路の渋滞情報

これらの情報を自動で集めて分析し、「渋谷オフィスを7時5分までに出発し、電車を使えば7時30分には、青山◯◯レストランに到着します」といった具体的なアドバイスをしてくれます。

このようなことが可能になるということは、 Apple Intelligenceが以下の高度な能力を持っていることを意味します:

- メッセージ履歴から私たちの予定を把握

- リアルタイムな交通情報の取得(電車の遅延状況や道路の渋滞情報)

- 外部データと個人データの連携による予測(交通情報、位置情報、予定など、複数の情報を組み合わせた分析)

つまり、Apple Intelligenceは私たちの予定を把握していて、発生した状況に応じて、 複数のアプリの情報を組み合わせた最適な解決策を提案してくれると言うことです。

と言うことは、 メッセージやカレンダーから

- 今日の朝から夜まで渋谷に行くという行動をApple Intelligenceが認識

- 渋谷は、夜雨が降ることをApple Intelligenceが自動収集

- iPhoneから傘を持って行くように提案される

というような機能も実装できそうですよね。

ChatGPTとの連携

WWDC 2024での発表の中で特に注目を集めたのが、Apple IntelligenceとChatGPTのシームレスな統合です。以下はその内容を具体的にご紹介します。

SiriとChatGPTが協力する新しい体験

SiriがChatGPTの専門知識を活用できるようになり、私たちの日常がさらに便利になります。

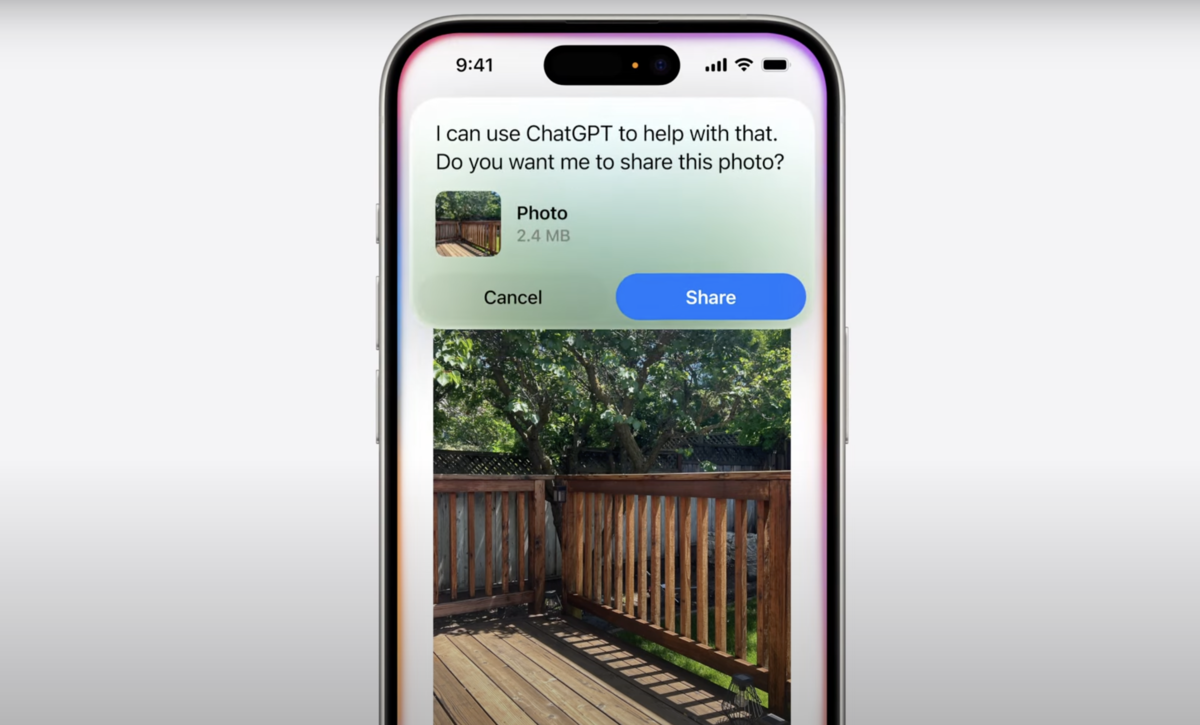

例えば、「友人に振る舞う新鮮な魚と家庭菜園の野菜を使ったレシピを教えて」と尋ねると、SiriがChatGPTにリクエストを共有して良いか確認した上で、アイデアを提案してくれます。

さらに、写真を撮って「このテラスにはどんな植物が合う?」と聞くと、その写真をもとに装飾や植栽のアドバイスを受けることも可能ということです。

いずれもChatGPTアプリを使えば実現できますが、いちいちアプリを開かなくてもSiri経由でChatGPTにアクセスできるというのはユーザーにとって良いことですね。

書類やプレゼンテーションのサポート

Apple Intelligenceでは、ChatGPTを活用してPDFやプレゼンテーションの内容について質問したり、文章を生成したりすることが可能です。

例えば、ChatGPTに「6歳の娘が喜びそうな蝶となぞなぞをテーマにしたおとぎ話」を依頼すると、創造性豊かなストーリーがすぐに提供されます。

プライバシーを守りつつ、自由に利用可能

ChatGPTの統合においても、Appleはユーザーのプライバシーを最優先に考えています。

リクエスト内容や情報は記録されず、サブスクリプション登録者であれば、自分のアカウントでログインし有料機能を利用することも可能です。

また、いつChatGPTを利用するかはユーザーが完全にコントロールでき、情報が共有される前に必ず許可を求められます。

「当たり前になりつつある」AI機能も実装

Apple Intelligenceには、すでに他のAIサービスで見慣れた機能も実装されています。簡単にまとめてみましょう。

テキスト関連

- メールの要約機能:長文メールの内容を要約表示

- 返信文のサジェスト:状況に応じた返信文を提案

- 通知の重要度理解:緊急性の高い通知を優先表示

- 音声の文字起こし&要約:通話や録音した音声から文字起こしと要約を生成

- Siriの自然な会話理解:言い間違いや言い換えにも対応(例:「渋谷の天気は?」→「間違えた、原宿の方」)

画像/アート関連

- Image Playground:テキストプロンプトから画像を生成

- Image Wand:ラフスケッチを洗練された画像に修正

- Genmoji:テキストから状況に合った絵文字を生成

写真/ビデオ関連

- クリーンアップツール:写真の背景から不要な物を自動で削除

- 高度な写真/ビデオ検索:自然言語での詳細な検索が可能(例:「絞り染めTシャツでスケボーするMaya」「芝生で側転するMariaの動画」)

- AIによる思い出ビデオ作成:テーマを入力するだけで、関連する写真・動画を選択し、ストーリー性のある動画を自動生成(音楽付き)

これらの機能は、すでにChatGPTやNotion AI、Gemini、Google Photos、Adobe Photoshopなどの各種AIサービスで提供されている機能ですが、各種サービスにアクセスせずにiPhoneから直接実行できるようになったのはユーザーにとって便利になるかもしれないですね。

そんなに個人情報を渡して大丈夫なの?

ここまで紹介してきたように、Apple Intelligenceは私たちの個人情報にかなり深部まで広範囲にアクセスします。メッセージ、写真、メール、カレンダーなど、プライバシーに関わる情報を理解し活用するため、当然ながらプライバシーとセキュリティの懸念が生じますよね。

この課題に対してAppleは、「オンデバイスAI」を基盤とする独自のアプローチを採用しています。

オンデバイスAIとは?

Apple Intelligenceの処理の多くは、ユーザーのデバイス(iPhone、iPad、Mac)上で直接実行されます。これにより:

- 個人データがクラウドに送信されない

- データの保存場所やアクセス権限をユーザーが完全にコントロール

- インターネット接続なしでも機能する

と言うことを実現しています。 サーバーに情報を送らないから個人情報を守るというアプローチです。

なぜ実現できるのでしょうか?

このアプローチを可能にしているのは、OpenAI(ChatGPT)などと異なり、Appleがデバイスを自社開発しているからです。

- 最新のiPhone、iPad、macにAI処理のための専用演算基盤を搭載

- ハードウェアとソフトウェアの緊密な統合

このため Apple Intelligenceは、iPhone 16、iPhone 16 Plus、iPhone 16 Pro、iPhone 16 Pro Max、iPhone 15 Pro、iPhone 15 Pro Max、A17 ProまたはM1以降を搭載したiPad、M1以降を搭載したMacといった新しい高スペックなデバイスしか利用できないと言うことです。

より大規模なAI処理が必要な場合は?

より複雑な処理が必要な場合のために、Appleは「Private Cloud Compute」という新しい仕組みを導入しています。

これは通常のクラウドサービスとは異なり:

- 永続的なストレージ機能も持たない

- 処理に必要な最小限のデータのみを暗号化して処理

- サーバー上で実行されるコードは外部の独立した専門家によって検証

Appleは利用されるデータは厳重に守られていて、AI処理以外の用途では使用しないとアナウンスしています。

Apple Intelligenceはディベロッパーに何を求めるか

これまでApple Intelligenceがユーザーの生活をどのように変えるか見てきました。

では、開発者である私たちは、この進化にどう対応すればいいのでしょうか?

結論から言うと、Apple Intelligenceが自動的にアプリ内の情報を解読してくれるという言うことは無く、アプリ側からApple Intelligenceに情報を連携する必要があります。

Apple Intelligence対応への必要な準備について見ていきましょう。

Apple Intelligenceとの連携について

Apple Intelligenceとアプリを連携するためには、開発者側からAppleのフレームワークを用いてさまざまな情報を提供する必要があります。

ここでは、一例を見ながら解説しましょう。

「妻がこの前送ってきてたNHKニュースのポッドキャストを再生して」とSiriに言うと、ポッドキャストアプリが起動して直接再生が始まる。

これを実現するために、ポッドキャストがApple Intelligenceに提供する必要がある情報は次のとおりです:

- ポッドキャストが音楽再生機能を有すること

- NHKニュースというコンテンツ名

- コンテンツがアプリ内のどこにあるか

以下で、これらを実現するための実装について説明します。

1. ポッドキャストが音楽再生機能を有すること

コード上からApp Intentというフレームワークを用いてポッドキャストが音楽再生機能を持つことを登録します。

これによりポッドキャストは「音楽再生機能がある」という情報がApple Intelligenceに共有されて、

Siriや他のアプリから「音楽を再生する」機能にアクセスできるようになります。

WWDCでは、アプリ内の全ての機能をApp Intentに登録することが推奨されていました。

これは開発者にとって大きな挑戦ですが、その結果、ユーザー体験を大幅に向上させることが期待されるので進めていきたいですね。

2. コンテンツ名の登録

コンテンツ名を提供するためには、App Entitiesというフレームワークを使用します。

これは、コンテンツのタイトル、説明、カテゴリといった情報を簡単にエンティティとして定義できるそうです。

この構造を使うことで、Siriが「NHKニュース」を検索できるようになります。

3. コンテンツがアプリ内のどこにあるのか登録

これはユニバーサルリンクという仕組みを利用して登録します。

ユニバーサルリンクとは、アプリの外からアプリ内の任意の特定画面に遷移させることができる仕組みのことです。

ユニバーサルリンクを活用して、Apple Intelligenceにコンテンツがアプリの中のどこの画面にあるのか場所を伝えることで、Siriがアプリ内の特定のコンテンツに直接アクセスできるようになります。

Apple Intelligenceがユーザーの生活にとっても私たちディベロッパーの仕事にとっても大きなインパクトを持ちそうだということがわかりました。

では、次は実際にApple Intelligenceがユーザーからどの程度注目されているかGoogle Trendsを使って確認していきましょう。

Apple Intelligenceの注目度を可視化してみる

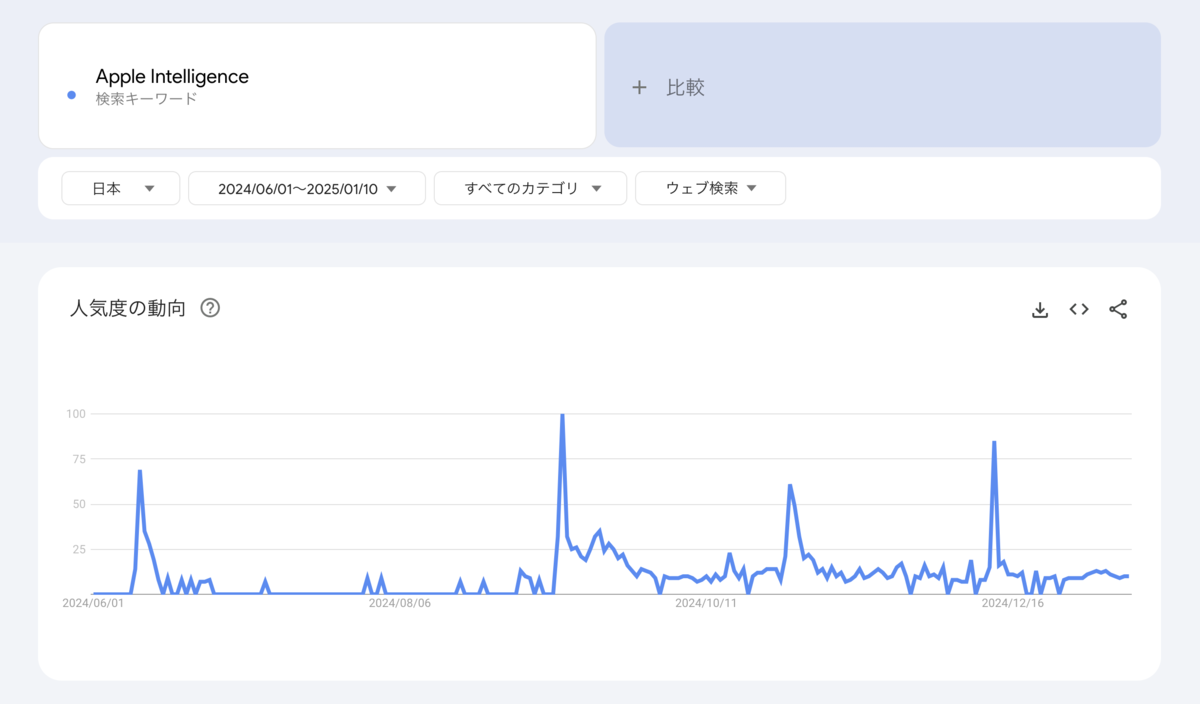

Google検索における検索ボリュームをグラフ化したものを見ていきましょう。

日本国内における「Apple Intelligence」の検索トレンド

日本ではニュース発表時の急激な盛り上がりと急速な関心低下が特徴的ですね。

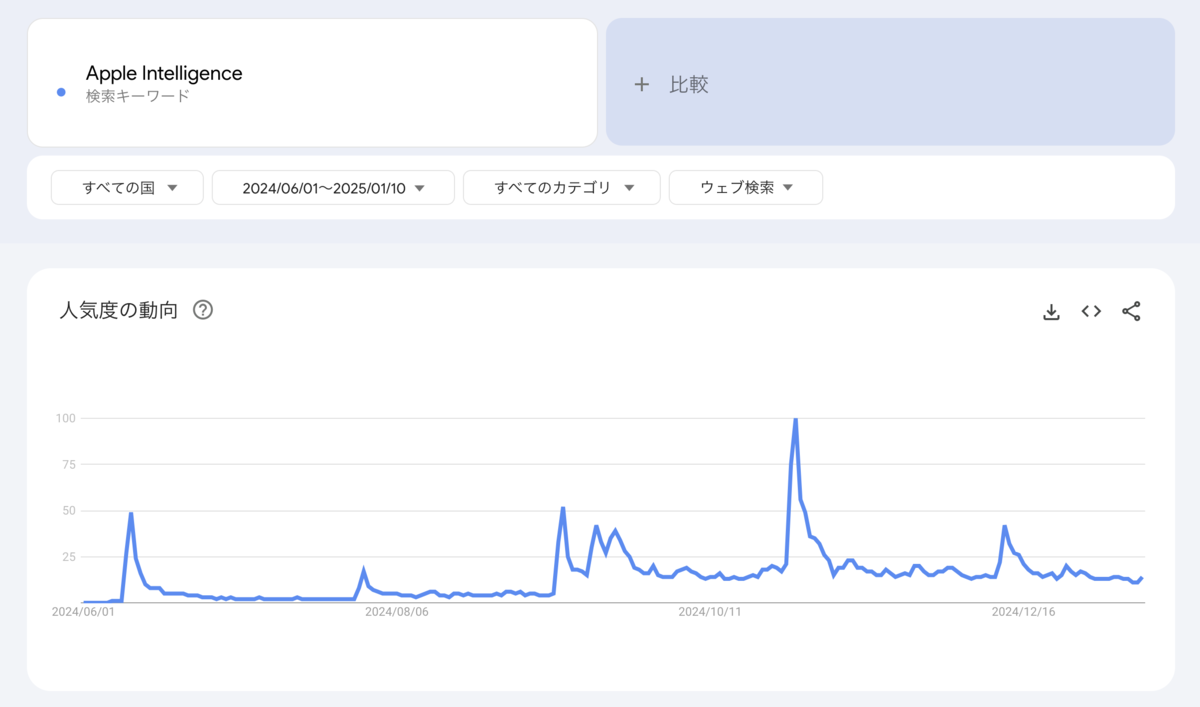

アメリカにおける「Apple Intelligence」の検索トレンド

このグラフは2024年6月1日から2025年1月10までのアメリカ国内の検索ボリュームです。

アメリカと日本のApple Intelligenceへの関心を比較すると、

アメリカではイベントの後の関心が持続的な傾向であり、関心レベルが徐々に上昇傾向であると読み取れます。

この日本とアメリカの差は、アメリカではApple Intelligenceの利用が開始されているからですね。

では、次は実際にApple Intelligenceを利用している海外ユーザーの声を聞いてみましょう。

海外ユーザーの声と評価

X(旧Twitter)から声を集めました。

好意的な意見

I’m definitely liking the Apple Intelligence mail app. #Apple #iPhone #iOS #iPhone16 #iPhone16ProMax #iOS18 pic.twitter.com/usNSyI6OHv

— Apple Snob 😝 (@AppleSnob_) 2024年12月12日

このユーザーは、Apple Intelligenceのメール分類機能が気に入っていると言っています。

Initially, I found the product to be rather lacking in substance. However, upon its regular use, I discovered its remarkable capabilities and have since incorporated it into various aspects of my workflow.

— DraxTheDad (@drax_the_dad) 2025年1月13日

このユーザーは、最初はApple Intelligenceに物足りなさを感じていたが定期的に使用するうちに、利用価値がわかり、利用を続けている。と言っています。

i use it. for text completion, summarizes slack messages and emails. the siri functionality has improved but could be better.

— mar.io (@i_killed_aliens) 2025年1月12日

このユーザーは、Slackのメッセージやメールの要約機能が気に入っているようです。

批判的な意見

Need Siri / Apple Intelligence to be a bit more intelligent than funny pic.twitter.com/dHl8WO2Upl

— rohit (@rohitghosh_) 2024年12月26日

このユーザーは、Siriに韓国ウォンをアメリカドルに換算してと依頼したものの、正確な回答ではなかったと言っています。 質問に対してSiriはユーモラスな回答をしたので、面白さよりももう少し知性が必要だと言っていますね。

First victim of Apple intelligence is Apple Mail. The new intelligent design makes it mostly useless. Now it takes multiple clicks to find an email or get to inbox zero. $AAPL pic.twitter.com/yX3JFvzs4Y

— Brahma Narayanan (@brahma_n) 2025年1月8日

Apple Intelligenceと直接関係なかったのですが、ご紹介します。

このユーザーは、Apple Intelligenceに伴うデザイン変更により、メールアプリのUIが変わってしまい、メールを探したり、受信トレイをゼロにするのに何度もクリックする必要があると言っていますね。

Apple has become a true disgrace. pic.twitter.com/dq1cmLpPmO

— Tejas Kumar (@TejasKumar_) 2025年1月13日

このユーザーはmacOSの設定アプリにおける検索機能の不具合を指摘しています。

ユーザーは以下の手順をしたものの、結果が期待値にならないと伝えています。

- 設定アプリの検索窓で「Privacy & Security」を検索する

- 動画の最初から、検索窓に「Privacy & Security」と入力していますが、結果は「No Results」と表示されます。

これは、「プライバシーとセキュリティ」という設定項目があるにも関わらず、macOSの検索機能がそれを認識できていないことを示しています。

このpostに対する返信で、iOSも同じように設定アプリからの検索性の悪く、毎回異なる検索結果が表示される。というコメントもありました。

ということで、

Xのpostから好意的な意見と批判的な意見でした。

実際の生の声がわかったところで、次に統計を見て俯瞰してみましょう。

Apple Intelligenceのユーザー利用調査について

Apple Intelligence利用のアンケート*1をご紹介いたします。

調査概要

- 期間:2024年11月28日〜12月6日

- 対象:AI対応のiPhone(iPhone 16シリーズ、iPhone 15 Pro、iPhone 15 Pro Max)ユーザー1000人以上

- 調査機関:SellCell(アメリカ携帯電話販売業者)

主な調査結果

Apple Intelligence について、

73%ものAppleユーザーが「あまり役に立たない」「あまり利用価値を感じない」と判断していることが分かりました。

AI機能を使用しない理由として以下が挙げられています:

- 最新ソフトウェアに更新していない (57.6%)

- 有用性を感じない (36.7%)

- AIの精度を信頼していない (18.2%)

有用性を感じないユーザーが36.7%いることは、AIがもたらす具体的なメリットが十分に伝わっていないように読み取れます。

これは新技術導入期の過渡期的な現象とも考えられますが、Appleにとっては「より分かりやすい価値提案」と「ユーザー教育の強化」が今後の課題になるかと思います。

ソフトウェアの更新を見送っているユーザー(57.6%)は、いわば「潜在的なユーザー層」と捉えることができます。

この層が実際にApple Intelligenceを使い始める時期までに、先行ユーザーのフィードバックを活かした機能改善や、より魅力的なユースケースの確立に期待したいですね。

一方で、27%のユーザーがApple Intelligenceを使いこなして、実生活にも役立っていると言っています。

人気を集める機能について見ていきましょう。

人気のあるAI機能:

- 文章作成ツール (72%)

- 通知のまとめ (54%)

- 優先メッセージ (44.5%)

- 写真のクリーンアップ (29.1%)

- スマートリプライ (20.9%)

面白い結果ですね。

興味深いのは、上位にランクインしている機能の多くが、すでに他のAIサービスや既存のアプリで提供されているものです。

特に文章作成ツールは ChatGPT やGemini でも利用可能ですし、通知のまとめや優先メッセージの機能は各種メールサービスでも提供されています。

それにもかかわらず、これらの機能がApple Intelligence内で高評価を得ているのは、おそらくiPhoneの中で完結して使えるという利便性が評価されているのではないでしょうか。

ただ、この調査結果を見る限り、Apple Intelligenceはまだまだ発展途上であり、多くのユーザーにとって「必須の機能」というところまでは至っていないようです。

また、Appleの標準アプリしか評価されておらずディベロッパーが作るアプリはApple Intelligenceとの本格的な連携、実装はまだできていないことも窺えます。

最後に

このような状況下からモバイルデバイスにおけるAIに関連するニュースは、

AIに意味があるのか?投資価値があるのか?といった懐疑的なものが多く散見されるようになりました。

X(旧Twitter)上でも、ディベロッパーと思われるユーザーたちでApple IntelligenceはiPhoneに必要か不要かの議論がなされていました。

私は、私たちディベロッパーは、Apple Intelligenceが有益か無益か判断する立場になく、むしろユーザーにとって有益なものにすることが存在意義だと考えています。

今後、数ヶ月から数年の間に新しく考える要件や実装が増えそうですが、Appleユーザーとしてもディベロッパーとしても、とてもワクワクしています。

チームメンバーと共に、この進化を私たちが社会実装するという思いで挑戦できたらいいなと思いました。

以上となります。最後までお読みいただきありがとうございました。

参考

基調講演 - WWDC24 - ビデオ - Apple Developer

Bring your app’s core features to users with App Intents - WWDC24 - Videos - Apple Developer

Platforms State of the Union - WWDC24 - ビデオ - Apple Developer

システムの利便性を高めるApp Intentのデザイン - WWDC24 - ビデオ - Apple Developer

App Intentの新機能 - WWDC24 - ビデオ - Apple Developer

Writing Toolsの導入 - WWDC24 - ビデオ - Apple Developer

ジェン文字でアプリに表情を追加 - WWDC24 - ビデオ - Apple Developer

What’s new in AppKit - WWDC24 - Videos - Apple Developer

*1:引用元:SellCell調査レポート